|

Главная |

Активационная функция искусственного нейрона

|

из

5.00

|

Контрольная работа

Медицинские экспертные системы

Содержание

1. Арифметические операции над нечеткими множествами

2. Активационная функция искусственного нейрона

3. Назначение и особенности экспертных систем

Арифметические операции над нечеткими множествами

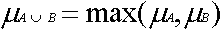

ОБЪЕДИНЕНИЕ: создается новое множество из элементов исходных множеств, причем для одинаковых элементов принадлежность берется максимальной(критерий максимума).

ПЕРЕСЕЧЕНИЕ: создается новое множество из одинаковых элементов исходных множеств, принадлежность которых берется минимальной(критерий минимуима).

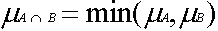

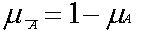

ДОПОЛНЕНИЕ: инвертируется принадлежность каждого элемента.

СТЕПЕНЬ: принадлежность каждого элемента возводится в степень.

CON - концентрация, степень=2 (уменьшает степень нечеткости)

DIN - растяжение, степень=1/2 (увеличивает степень нечеткости)

РАЗНОСТЬ: новое множество состоит из одинаковых элементов исходных множеств.

A - B = {<Ma-b(x)/x>}

Ma-b(x) = Ma(x)-Mb(a), если Ma(x)>Mb(x)

НОСИТЕЛЬ: состоит из элементов исходного множества, принадлежности которых больше нуля.

Supp(A) = {x|x?X /\ Ma(x)>0}

УМНОЖЕНИЕ НА ЧИСЛО: принадлежности элементов домножаются на число.

q*A = {<q*Ma(x)/x>}

СУПРЕМУМ: Sup - точная верхняя грань (максимальное значение принадлежности, присутствующее в множестве).

НОРМАЛИЗАЦИЯ: нечеткое множество нормально если супремум множества равен единице. Для нормализации перечитывают принадлежности элементов:

M'a(x) = Ma(x)/(Sup Ma(x))

АЛЬФА-СРЕЗ: множество альфа уровня - те элементы исходного множества, принадлежность которых выше или равна заданного порога. Порог, равный 1/2, называют точкой перехода.

Aq = {x|x?X /\ Ma(x)>q}

НЕЧЕТКОЕ ВКЛЮЧЕНИЕ: степень включения нечеткого множества

V(A1,A2) = (Ma1(x0)->Ma2(x0))&(Ma1(x1)->Ma2(x1))&..

По Лукасевичу:

Ma1(x)->Ma2(x) = 1&(1-Ma1(x)+Ma2(x))

По Заде:

Ma1(x)->Ma2(x) = (1-Ma1(x)) \/ Ma2(x)

НЕЧЕТКОЕ РАВЕНСТВО: степень нечеткого равенства

R(A1,A2) = V(A1,A2) & V(A2,A1)

Активационная функция искусственного нейрона

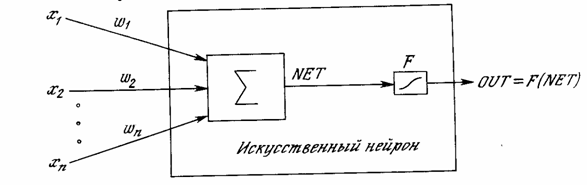

Искусственный нейрон

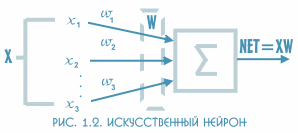

Искусственный нейрон имитирует свойства биологического нейрона. На вход искусственного нейрона поступает некоторое множество сигналов, каждый из которых является выходом другого нейрона. Каждый вход умножается на соответствующий весовой коэфициент, аналогичный синаптической силе, и все произведения суммируются, определяя уровень активации нейрона. На рис. 1.2 представлена модель, реализующая эту идею. Хотя сетевые парадигмы весьма разнообразны, в основе почти всех их лежит эта конфигурация. Здесь множество входных сигналов, обозначенных x1, x2,:, xn, поступает на искусственный нейрон. Эти входные сигналы, в совокупности, обозначаемые вектором X, соответствуют сигналам, приходящим в синапсы биологического нейрона. Каждый сигнал умножается на соответствующий весовой коэфициент w1, w2,..., wn, и поступает на суммирующий блок, обозначенный ∑. Каждый коэфициент соответствует "силе" одной биологической синаптической связи. (Множество коэфициентов в совокупности обозначается вектором W.) Суммирующий блок, соответствующий телу биологического элемента, складывает взвешенные входы алгебраически, создавая выход, который мы будем называть NET. В векторных обозначениях это может быть компактно записано следующим образом:

NET = XW.

Активационные функции

Сигнал NET далее, как правило, преобразуется активационной функцией F и дает выходной нейронный сигнал OUT. Активационная функция может быть обычной линейной функцией

OUT = K(NET),

где К - постоянная, пороговой функции

OUT = 1, если NET > T,

OUT = 0 в остальных случаях,

где Т - некоторая постоянная пороговая величина, или же является функцией, более точно моделирующей нелинейную передаточную характеристику биологического нейрона и представляющей нейронной сети большие возможности.

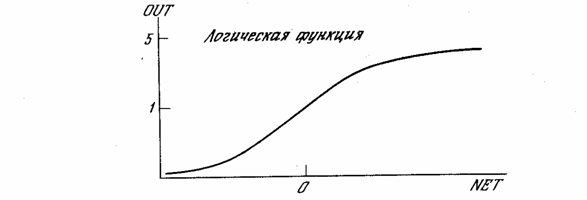

Если функция F сужает диапазон изменения величины NET так, что при любых значениях NET значения OUT принадлежат некоторому конечному интервалу, то F называется "сжимающей" функцией. В качестве "сжимающей" функции часто используется логистическая или "сигмоидальная" (S-образная) функция. Эта функция математически выражается как F(x) = 1/(1 + е-x). Таким образом,

OUT=1/(1+e-NET)

По аналогии с электронными системами активационную функцию можно считать нелинейной усилительной характеристикой искусственного нейрона. Коэффициент усиления вычисляется как отношение приращения величины OUT к вызвавшему его небольшому приращению величины NET. Он выражается наклоном кривой при определенном уровне возбуждения и изменяется от малых значений при больших отрицательных возбуждениях (кривая почти горизонтальна) до максимального значения при нулевом возбуждении и снова уменьшается, когда возбуждение становится большим положительным. Гроссберг (1973) обнаружил, что подобная нелинейная характеристика решает поставленную им дилемму шумового насыщения. Каким образом одна и та же сеть может обрабатывать как слабые, так и сильные сигналы? Слабые сигналы нуждаются в большом сетевом усилении, чтобы дать пригодный к использованию выходной сигнал. Однако усилительные каскады с большими коэффициентами усиления могут привести к насыщению выхода шумами усилителей (случайными флуктуациями), которые присутствуют в любой физически реализованной сети. Сильные входные сигналы в свою очередь также будут приводить к насыщению усилительных каскадов, исключая возможность полезного использования выхода. Центральная область логистической функции, имеющая большой коэффициент усиления, решает проблему обработки слабых сигналов, в то время как области с падающим усилением на положительном и отрицательном концах подходят для больших возбуждений. Таким образом, нейрон функционирует с большим усилением в широком диапазоне уровня входного сигнала.

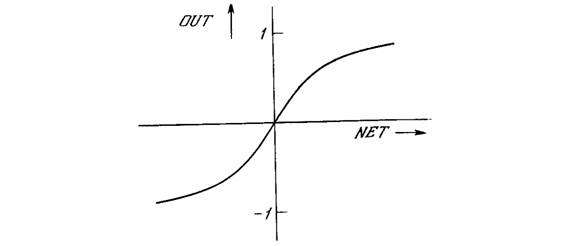

Другой широко используемой активационной функцией является гиперболический тангенс. По форме она сходна с логистической функцией и часто используется биологами в качестве математической модели активации нервной клетки.

В качестве активационной функции искусственной нейронной сети она записывается следующим образом:

OUT = th(x).

Подобно логистической функции гиперболический тангенс является S-образной функцией, но он симметричен относительно начала координат, и в точке NET = 0 значение выходного сигнала OUT равно нулю. В отличие от логистической функции гиперболический тангенс принимает значения различных знаков, что оказывается выгодным для ряда сетей.

|

из

5.00

|

Обсуждение в статье: Активационная функция искусственного нейрона |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы