|

Главная |

Определение пропускной способности канала связи

|

из

5.00

|

Своевременность связи в каждом направлении зависит от пропускной способности каналов, квалификации операторов, отработанности подразделений, правил станционно-эксплуатационной службы (СЭС). Влияние на нее оказывает структура системы связи (наличие прямых каналов связи и пунктов переприема, количество радиостанций в радиосети и др.) и использование связи (объем сообщений, подаваемых на средства связи; правильность адресования и т. д.), а в современных системах – степень автоматизации процессов передачи информации и работы постов связи.

Черты случайности, присущие процессам передачи информации, целесообразно рассматривать вероятностными методами. Основная задача теории своевременной передачи информации ставится следующим образом: имеется источник информации, непрерывно вырабатывающий информацию, и канал связи, по которому эта информация передается другому корреспонденту. Какова должна быть пропускная способность канала связи для того, чтобы канал «справлялся» со своей задачей, т.е. передавал всю поступающую информацию без задержек и искажений?

Рассмотрим некоторую систему связи X, которая может принимать конечное множество состояний: x1, x2,…, xn с вероятностями p1, p2,…, pn, где pi = P(X~ xi ) − вероятность того, что система X примет состояние xi , (выражение X~ xi обозначает событие: система находится в состоянии xi ). Очевидно,  .

.

Запишем эти данные в виде таблицы, где в верхней строке перечислены возможные состояния системы, а в нижней – соответствующие вероятности:

| xi | x1 | x2 | … | xn |

| pi | p1 | p2 | … | pn |

Эта таблица по написанию сходна с рядом распределения прерывной случайной величины X с возможными значениями x1, x2,…, xn имеющими вероятности p1, p2,…, pn. И действительно, между системой X с конечным множеством состояний и прерывной случайной величиной много общего; для того чтобы свести первую ко второй, достаточно приписать каждому состоянию какое-то числовое значение (скажем, номер состояния). Для описания степени неопределенности системы совершенно неважно, какие именно значения x1, x2,…, xn записаны в верхней строке таблицы; важны только количество этих значений и их вероятности.

В качестве меры априорной неопределенности системы (или прерывной случайной величины X) в теории информации применяется специальная характеристика, называемая энтропией. Понятие об энтропии является в теории информации основным.

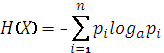

Энтропией системы называется сумма произведений вероятностей различных состояний системы на логарифмы этих вероятностей, взятая с обратным знаком:

(2.3)

(2.3)

Знак минус перед суммой поставлен для того, чтобы энтропия была положительной (числа р меньше единицы и их логарифмы отрицательны).

Энтропия H(X) обладает рядом свойств, оправдывающих ее выбор в качестве характеристики степени неопределенности. Во-первых, она обращается в нуль, когда одно из состояний системы достоверно, а другие – невозможны. Во-вторых, при заданном числе состояний она обращается в максимум, когда эти состояния равновероятны, а при увеличении числа состояний – увеличивается. Наконец, она обладает свойством аддитивности, т. е. когда несколько независимых систем объединяются в одну, их энтропии складываются.

Логарифм в формуле (2.3) может быть взят при любом основании а > 1. Перемена основания равносильна простому умножению энтропии на постоянное число, а выбор основания равносилен выбору определенной единицы измерения энтропии. Если за основание выбрано число 10, то говорят о «десятичных единицах» энтропии, если 2 – о «двоичных единицах». На практике удобнее всего пользоваться логарифмами при основании 2 и измерять энтропию в двоичных единицах; это хорошо согласуется с применяемой в цифровых каналах связи двоичной системой счисления.

Примем а = 2.

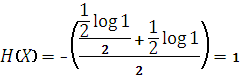

Легко убедиться, что при выборе 2 в качестве основания логарифмов за единицу измерения энтропии принимается энтропия простейшей системы X, которая имеет два равновозможных состояния:

| x i | x1 | x2 |

| pi |

|

|

По формуле (2.3) имеем

Определенная таким образом единица энтропии называется «двоичной единицей» и иногда обозначается bit (от англ. «binary digit» – двоичный знак). Это энтропия одного разряда двоичного числа, если он с одинаковой вероятностью может быть нулем или единицей.

|

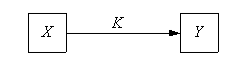

Пусть имеется источник информации X и приемник Y, связанные каналом связи К (рис. 2.4).

Рис. 2.4. Направление передачи информации

Известна производительность источника информации H1(X), т. е. среднее количество двоичных единиц информации, поступающее от источника в единицу времени (численно оно равно средней энтропии сообщения, производимого источником в единицу времени). Пусть, кроме того, известна пропускная способность канала С1, т.е. максимальное количество информации (например, двоичных знаков 0 или 1), которое способен передать канал в ту же единицу времени. Возникает вопрос: какова должна быть пропускная способность канала, чтобы он «справлялся» со своей задачей, т. е. чтобы информация от источника Х к приемнику Y поступала без задержки?

Ответ на этот вопрос дает первая теорема Шеннона.

1-я теорема Шеннона: если пропускная способность канала связи С1 больше энтропии источника информации в единицу времени С1 > H1(X), то всегда можно закодировать достаточно длинное сообщение так, чтобы оно передавалось каналом связи без задержки. Если же, напротив, С1 < H1(X), то передача информации без задержек невозможна.

Задание: определить пропускную способность канала связи, способного передавать К=110 символов 0 или 1 в единицу времени, причем каждый из символов искажается (заменяется противоположным) с вероятностью μ=0,03.

Дано: К=110; μ=0,03.

Определить: С

Решение:

1. По табл. П.2.1:

η(μ) = η(0,03) = 0,1518

η(1-μ) = η(1-0,03) = η(0,97) = 0,0426

2. η(μ) + η(1-μ) = 0,1518 + 0,0426 = 0,1944

3.

На один символ теряется информация 0,1944 двоичных единиц.

4. Пропускная способность канала равна

С = 110 (1-0,1944) ≈ 88,6 двоичных единиц в единицу времени

Для увеличения пропускной способности канала без помех используют следующие способы:

1. Использование для кодирования информации более двух состояний (одновременное изменение комбинации фазы и амплитуды в одном такте);

2. Применение логического кодирования с использованием сжатием (архивированием) информационного блока;

3. Использование дискретных систем связи с учетом того, что часть из них не будет служить для синхронизации или для обнаружения и исправления ошибок;

4. Увеличение до значительных величин количество состояний информационного сигнала (формула Найквиста).

|

из

5.00

|

Обсуждение в статье: Определение пропускной способности канала связи |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы