|

Главная |

Признаки наличия и показатели уровня мультиколлинеарности

|

из

5.00

|

1. Когда среди парных коэффициентов корреляции объяснительных переменных есть такие, уровень которых приближается или равна множественном коэффициента корреляции, то это означает возможность существования мультиколлинеарности. Информацию о парную зависимость может дать симметричная матрица коэффициентов парной корреляции или корреляции нулевого порядка между пояснительными переменными/

Однако когда к модели входят более двух объяснительные переменные, то изучение вопроса о мультиколинеарнисть не может ограничиваться информации, которую дает эта матрица. Явление мультиколлинеарности в коем случае не сводится лишь к существованию парной корреляции между независимыми переменными.

Более общая проверка предусматривает нахождение определителя (детерминанта) матрицы r, который называется детерминантом корреляции и обозначается │r│. Числовые значения детерминанта корреляции удовлетворяют условию: │r│принадлежит (1;0).

2. Если │r│= 0, то существует полная мультиколинеарнисть, а когда │r│= 1, мультиколинеарнисть отсутствует. Чем ближе │r│к нулю, тем вернее можно утверждать, что между пояснительными переменными существует мультиколинеарнисть. Несмотря на то, что на числовое значение │r│влияет дисперсия объяснительных переменных, этот показатель можно считать точечной мере уровня мультиколлинеарности.

_________________

Наибольшие затруднения в использовании аппарата множественной регрессии возникают при наличии мультиколлинеарности факторных переменных, когда более чем два фактора связаны между собой линейной зависимостью.

Мультиколлинеарностью для линейной множественной регрессии называется наличие линейной зависимости между факторными переменными, включёнными в модель.

Мультиколлинеарность – нарушение одного из основных условий, лежащих в основе построения линейной модели множественной регрессии.

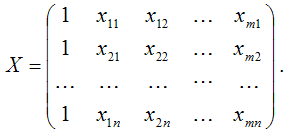

Мультиколлинеарность в матричном виде – это зависимость между столбцами матрицы факторных переменных Х:

Если не учитывать единичный вектор, то размерность данной матрицы равна n*n. Если ранг матрицы Х меньше n, то в модели присутствует полная или строгая мультиколлинеарность. Но на практике полная мультиколлинеарность почти не встречается.

Можно сделать вывод, что одной из основных причин присутствия мультиколлинеарности в модели множественной регрессии является плохая матрица факторных переменных Х.

Чем сильнее мультиколлинеарность факторных переменных, тем менее надежной является оценка распределения суммы объясненной вариации по отдельным факторам с помощью метода наименьших квадратов.

Включение в модель мультиколлинеарных факторов нежелательно по нескольким причинам:

1) основная гипотеза о незначимости коэффициентов множественной регрессии может подтвердиться, но сама модель регрессии при проверке с помощью F-критерия оказывается значимой, что говорит о завышенной величине коэффициента множественной корреляции;

2) полученные оценки коэффициентов модели множественной регрессии могут быть неоправданно завышены или иметь неправильные знаки;

3) добавление или исключение из исходных данных одного-двух наблюдений оказывает сильное влияние на оценки коэффициентов модели;

4) мультиколлинеарные факторы, включённые в модель множественной регрессии, способны сделать её непригодной для дальнейшего применения.

Конкретных методов обнаружения мультиколлинеарности не существует, а принято применять ряд эмпирических приёмов. В большинстве случаев множественный регрессионный анализ начинается с рассмотрения корреляционной матрицы факторных переменных R или матрицы (ХТХ).

37. Методы борьбы с мультиколлинеарностью

К основным способам устранения мультиколлинеарности в модели множественной регрессии относятся:

1) один из наиболее простых способов устранения мультиколлинеарности состоит в получении дополнительных данных. Однако на практике в некоторых случаях реализация данного метода может быть весьма затруднительна;

2) способ преобразования переменных, например, вместо значений всех переменных, участвующих в модели (и результативной в том числе) можно взять их логарифмы.

Однако данный способ также не способен гарантировать полного устранения мультиколлинеарности факторов.

Если рассмотренные способы не помогли устранить мультиколлинеарность факторов, то переходят к использованию смещённых методов оценки неизвестных параметров модели регрессии, или методов исключения переменных из модели множественной регрессии.

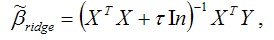

Если ни одну из факторных переменных, включённых в модель множественной регрессии, исключить нельзя, то применяют один из основных смещённых методов оценки коэффициентов модели регрессии – гребневую регрессию или ридж (ridge).

При использовании метода гребневой регрессии ко всем диагональным элементам матрицы (ХТХ) добавляется небольшое число: 10-6 ‹ ‹ 0.1. Оценивание неизвестных параметров модели множественной регрессии осуществляется по формуле:

Результатом применения гребневой регрессии является уменьшение стандартных ошибок коэффициентов модели множественной регрессии по причине их стабилизации к определённому числу.

Метод главных компонент является одним из основных методов исключения переменных из модели множественной регрессии.

Данный метод используется для исключения или уменьшения мультиколлинеарности факторных переменных модели регрессии. Суть метода заключается в сокращении числа факторных переменных до наиболее существенно влияющих факторов. Это достигается с помощью линейного преобразования всех факторных переменных xi (i=0,…,n) в новые переменные, называемые главными компонентами, т. е. осуществляется переход от матрицы факторных переменных Х к матрице главных компонент F. При этом выдвигается требование, чтобы выделению первой главной компоненты соответствовал максимум общей дисперсии всех факторных переменных xi (i=0,…,n), второй компоненте – максимум оставшейся дисперсии, после того как влияние первой главной компоненты исключается и т. д.

Метод пошагового включения переменных состоит в выборе из всего возможного набора факторных переменных именно те, которые оказывают существенное влияние на результативную переменную.

Метод пошагового включения осуществляется по следующему алгоритму:

1) из всех факторных переменных в модель регрессии включаются те переменные, которым соответствует наибольший модуль линейного коэффициента парной корреляции с результативной переменной;

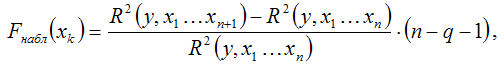

2) при добавлении в модель регрессии новых факторных переменных проверяется их значимость с помощью F-критерия Фишера. При том выдвигается основная гипотеза о необоснованности включения факторной переменной xk в модель множественной регрессии. Обратная гипотеза состоит в утверждении о целесообразности включения факторной переменной xk в модель множественной регрессии. Критическое значение F-критерия определяется как Fкрит(a;k1;k2), где а – уровень значимости, k1=1 и k2=n–l – число степеней свободы, n – объём выборочной совокупности, l – число оцениваемых по выборке параметров. Наблюдаемое значение F-критерия рассчитывается по формуле:

где q – число уже включённых в модель регрессии факторных переменных.

При проверке основной гипотезы возможны следующие ситуации.

Если наблюдаемое значение F-критерия (вычисленное по выборочным данным) больше критического значения F-критерия (определённого по таблице распределения Фишера-Снедекора), т. е. Fнабл›Fкрит, то основная гипотеза о необоснованности включения факторной переменной xk в модель множественной регрессии отвергается. Следовательно, включение данной переменной в модель множественной регрессии является обоснованным.

Если наблюдаемое значение F-критерия (вычисленное по выборочным данным) меньше или равно критического значения F-критерия (определённого по таблице распределения Фишера-Снедекора), т. е. Fнабл<=Fкрит, то основная гипотеза о необоснованности включения факторной переменной xk в модель множественной регрессии принимается. Следовательно, данную факторную переменную можно не включать в модель без ущерба для её качества

3) проверка факторных переменных на значимость осуществляется до тех пор, пока не найдётся хотя бы одна переменная, для которой не выполняется условие Fнабл›Fкрит.

_____

Методы устранения мультиколлинеарности

Существует два основных подхода к решению этой задачи.

§ Метод дополнительных регрессий

§ Строятся уравнения регрессии, которые связывают каждый из регрессоров со всеми остальными

§ Вычисляются коэффициенты детерминации  для каждого уравнения регрессии

для каждого уравнения регрессии

§ Проверяется статистическая гипотеза  с помощью F-теста

с помощью F-теста

Вывод: если гипотеза  не отвергается, то данный регрессор не приводит к мультиколлинеарности.

не отвергается, то данный регрессор не приводит к мультиколлинеарности.

§ Метод последовательного присоединения

§ Строится регрессионная модель с учетом всех предполагаемых регрессоров. По признакам делается вывод о возможном присутствии мультиколлинеарности

§ Расчитывается матрица корреляций и выбирается регрессор, имеющий наибольшую корреляцию с выходной переменной

§ К выбранному регрессору последовательно добавляются каждый из оставшихся регрессоров и вычисляются скорректированные коэффициенты детерминации для каждой из моделей. К модели присоединяется тот регрессор, который обеспечивает наибольшее значение скорректированного

Процесс присоединения регрессоров прекращается, когда значение скорректированного  становится меньше достигнутого на предыдущем шаге.

становится меньше достигнутого на предыдущем шаге.

Каким бы образом не осуществлялся отбор факторов, уменьшение их числа приводит к улучшению обусловленности матрицы  , а, следовательно, и к повышению качества оценок параметров модели.

, а, следовательно, и к повышению качества оценок параметров модели.

38. Последствия гетероскедастичности

Последствия: 1. истинная не приводит к смещению оценок коэффициентов регрессии;

2. гетероскедастичность увеличивает дисперсию распределения оценок коэффициентов.

3. гетероскедастичность вызывает тенденцию к недооценке стандартных ошибок коэффициентов при использовании OLS (метод наименьших квадратов).

|

из

5.00

|

Обсуждение в статье: Признаки наличия и показатели уровня мультиколлинеарности |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы