|

Главная |

Математическое обоснование радиально-базисных сетей

|

из

5.00

|

Многослойные нейронные сети, с точки зрения математики, выполняют аппроксимацию стохастической функции нескольких переменных путем преобразования множества входных переменных  во множество выходных переменных

во множество выходных переменных  . Вследствие характера сигмоидальной функции активации осуществляется аппроксимация глобального типа, так как преобразование значения функции в произвольной точке пространства выполняется объединенными усилиями многих нейронов.

. Вследствие характера сигмоидальной функции активации осуществляется аппроксимация глобального типа, так как преобразование значения функции в произвольной точке пространства выполняется объединенными усилиями многих нейронов.

Другой способ отображения входного множества в выходное множество заключается в преобразовании путем адаптации нескольких одиночных аппроксимирующих функций к ожидаемым значениям, причем эта адаптация проводится только в локальной области многомерного пространства. При таком подходе отображение всего множества данных представляет собой сумму локальных преобразований, а скрытые нейроны составляют множество базисных функций локального типа.

Особое семейство образуют радиальные сети, в которых скрытые нейроны реализуют функции, радиально изменяющиеся вокруг выбранного центра и принимающие ненулевые значения только в окрестности этого центра. Подобные функции, определяемые в виде  , называются радиальными базисными функциями. В таких сетях роль скрытого нейрона заключается в отображении радиального пространства вокруг одиночной заданной точки либо вокруг группы таких точек, образующих кластер. Суперпозиция сигналов, поступающих от всех скрытых нейронов, которая выполняется выходным нейроном, позволяет получить отображение всего многомерного пространства.

, называются радиальными базисными функциями. В таких сетях роль скрытого нейрона заключается в отображении радиального пространства вокруг одиночной заданной точки либо вокруг группы таких точек, образующих кластер. Суперпозиция сигналов, поступающих от всех скрытых нейронов, которая выполняется выходным нейроном, позволяет получить отображение всего многомерного пространства.

Сети радиального типа представляют собой естественное дополнение сигмоидальных сетей. Сигмоидальный нейрон представляется в многомерном пространстве гиперплоскостью, которая разделяет это пространство на два класса, в которых выполняется одно из двух условий: либо  , либо

, либо  . Такой подход продемонстрирован на рис. 4.1а. В свою очередь радиальный нейрон представляет собой гиперсферу, которая осуществляет шаровое разделение пространства вокруг центральной точки (рис. 4.1б) [4].

. Такой подход продемонстрирован на рис. 4.1а. В свою очередь радиальный нейрон представляет собой гиперсферу, которая осуществляет шаровое разделение пространства вокруг центральной точки (рис. 4.1б) [4].

Именно с этой точки зрения радиальный нейрон является естественным дополнением сигмоидального нейрона, поскольку в случае круговой симметрии данных позволяет заметно уменьшить количество нейронов, необходимых для разделения различных классов.

| а) |

| б) |

Рис. 4.1 Иллюстрация способов разделения пространства данных:

а) сигмоидальным нейроном; б) радиальным нейроном

Так как нейроны могут выполнять различные базисные функции, в радиальных сетях отсутствует необходимость использования большого количества скрытых слоев. Структура типичной радиальной сети включает входной слой, на который подаются сигналы, описываемые входным вектором x, скрытый слой с нейронами радиального типа и выходной слой, состоящий, как правило, из одного или нескольких линейных нейронов. Функция выходного нейрона сводится исключительно к взвешенному суммированию сигналов, генерируемых скрытыми нейронами.

Математическую основу функционирования радиальных сетей составляет теорема Т. Ковера о разделимости образов, которая базируется на двух моментах [4]:

1. Определение нелинейной скрытой функции  , где x– входной вектор, а i=1,2,…,K, K – размерность скрытого пространства.

, где x– входной вектор, а i=1,2,…,K, K – размерность скрытого пространства.

2. Высокая размерность скрытого пространства по сравнению с размерностью входного. Эта размерность определяется количеством скрытых нейронов.

Если вектор радиальных функций  в N-мерном входном пространстве обозначить j(x), то это пространство является нелинейно j-разделяемым на два пространственных класса X+и X- тогда, когда существует такой вектор весов w, что

в N-мерном входном пространстве обозначить j(x), то это пространство является нелинейно j-разделяемым на два пространственных класса X+и X- тогда, когда существует такой вектор весов w, что

(4.1)

(4.1)

Граница между этими классами определяется уравнением  .

.

Ковер доказал, что каждое множество образов, случайным образом размещенных в многомерном пространстве, является  -разделяемым с вероятностью 1 при условии большой размерности K этого пространства. На практике это означает, что применение достаточно большого количества скрытых нейронов, реализующих радиальные функции

-разделяемым с вероятностью 1 при условии большой размерности K этого пространства. На практике это означает, что применение достаточно большого количества скрытых нейронов, реализующих радиальные функции  , гарантирует решение задачи классификации при построении всего лишь двухслойной сети. При этом скрытый слой должен реализовать вектор j(x), а выходной слой может состоять из единственного линейного нейрона, выполняющего суммирование выходных сигналов от скрытых нейронов с весовыми коэффициентами, заданными вектором w.

, гарантирует решение задачи классификации при построении всего лишь двухслойной сети. При этом скрытый слой должен реализовать вектор j(x), а выходной слой может состоять из единственного линейного нейрона, выполняющего суммирование выходных сигналов от скрытых нейронов с весовыми коэффициентами, заданными вектором w.

Простейшая нейронная сеть радиального типа функционирует по принципу многомерной интерполяции, состоящей в отображении p различных входных векторов  (t=1,2,…,p) из входного N-мерного пространства во множество из pрациональных чисел

(t=1,2,…,p) из входного N-мерного пространства во множество из pрациональных чисел  (t=1,2,…,p). Для реализации этого процесса необходимо использовать pскрытых нейронов радиального типа и задать такую функцию отображения F(x), для которой выполняется условие интерполяции:

(t=1,2,…,p). Для реализации этого процесса необходимо использовать pскрытых нейронов радиального типа и задать такую функцию отображения F(x), для которой выполняется условие интерполяции:

. (4.2)

. (4.2)

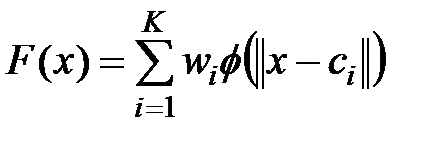

С практической же точки зрения использование в разложении большого числа pбазисных функций недопустимо, поскольку если число обучающих выборок велико и равно числу радиальных функций, то в результате вычислительная сложность обучающего алгоритма становится чрезмерной, а сама сеть адаптируется кразного рода шумам и нерегулярностям, сопровождающим обучающие выборки. Поэтому необходимо редуцировать количество весов, что приводит к уменьшению количества базисных функций. В этом случае ищется субоптимальное решение в пространстве меньшей размерности, которое с достаточной точностью аппроксимирует точное решение. Если ограничиться Kбазисными функциями, то аппроксимирующее решение можно представить в виде

, (4.3)

, (4.3)

где K<p, а  (i=1,2,…,K) – множество центров, которые необходимо определить. В особом случае, если принять K=p, то можно получить точное решение

(i=1,2,…,K) – множество центров, которые необходимо определить. В особом случае, если принять K=p, то можно получить точное решение  .

.

Задача аппроксимации состоит в подборе соответствующего количества радиальных функций  и их параметров, а также в таком подборе весов

и их параметров, а также в таком подборе весов  (i=1,2,…,K), чтобы решение уравнения (4.3) было наиболее близким к точному. Поэтому проблему подбора параметров радиальных функций и значений весов

(i=1,2,…,K), чтобы решение уравнения (4.3) было наиболее близким к точному. Поэтому проблему подбора параметров радиальных функций и значений весов  сети можно свести к минимизации целевой функции, которая при использовании метрики Эвклида записывается в форме

сети можно свести к минимизации целевой функции, которая при использовании метрики Эвклида записывается в форме

(4.4)

(4.4)

В этом уравнении K представляет количество радиальных нейронов, а p– количество обучающих пар  , где

, где  – это входной вектор, а

– это входной вектор, а  – соответствующий ему ожидаемый выходной вектор.

– соответствующий ему ожидаемый выходной вектор.

|

из

5.00

|

Обсуждение в статье: Математическое обоснование радиально-базисных сетей |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы