|

Главная |

Алгоритм обратного распространения ошибки

|

из

5.00

|

Алгоритм обратного распространения ошибки определяет стратегию подбора весов многослойной сети с применением градиентных методов оптимизации. В настоящее время считается одним из наиболее эффективных алгоритмов обучения многослойной сети. При обучении ставится задача минимизации целевой функции, формируемой, как правило, в виде квадратичной суммы разностей между фактическими и ожидаемыми значениями выходных сигналов, которая для P обучающих выборок определяется по формуле:

(2.7)

(2.7)

В случае единичной обучающей выборки (x,d) целевая функция имеет вид:

(2.8)

(2.8)

Уточнение весов может проводиться после предъявления каждой обучающей выборки (так называемый режим «онлайн»), при этом используется целевая функция вида (2.8), либо однократно после предъявления всех обучающих выборок (режим «оффлайн»), при этом используется целевая функция вида (2.7). В последующем изложении используется целевая функция вида (2.8).

Для упрощения можно считать, что цель обучения состоит в таком определении значений весов нейронов каждого слоя сети, чтобы при заданном входном векторе получить на выходе значения сигналов  , совпадающие с требуемой точностью с ожидаемыми значениями

, совпадающие с требуемой точностью с ожидаемыми значениями  при s= 1, 2,…,M.

при s= 1, 2,…,M.

Обучение сети с использованием алгоритма обратного распространения ошибки проводится в несколько этапов.

На первом из них предъявляется обучающая выборка x и рассчитываются значения сигналов соответствующих нейронов сети. При заданном векторе x определяются вначале значения выходных сигналов viскрытого слоя, а затем значенияys выходного слоя. Для расчета применяются формулы (2.1) и (2.2). После получения значений выходных сигналов  становится возможным рассчитать фактическое значение целевой функции ошибки E(w).

становится возможным рассчитать фактическое значение целевой функции ошибки E(w).

На втором этапе минимизируется значение этой функции.

Так как целевая функция непрерывна, то наиболее эффективными методами обучения оказываются градиентные алгоритмы, согласно которым уточнение вектора весов (обучение) производится по формуле:

, (2.9)

, (2.9)

где  , (2.10)

, (2.10)

h - коэффициент обучения, а p(w) – направление в многомерном пространстве w. В алгоритме обратного распространения ошибки p(w) определяется как частная производная  , взятая со знаком минус.

, взятая со знаком минус.

Обучение многослойной сети с применением градиентных методов требует определения вектора градиента относительно весов всех слоев сети, что необходимо для правильного выбора направления p(w). Эта задача имеет очевидное решение только для весов выходного слоя. Для других слоев используется алгоритм обратного распространения ошибки, который определяется следующим образом [4]:

1. Подать на вход сети вектор x и рассчитать значения выходных сигналов нейронов скрытых слоев и выходного слоя, а также соответствующие производные  функций активации каждого слоя (m – количество слоев).

функций активации каждого слоя (m – количество слоев).

2. Создать сеть обратного распространения ошибок путем изменения направления передачи сигналов, замены функций активации их производными и подачи на бывший выход сети в качестве входного сигнала разности между фактическими  и ожидаемыми

и ожидаемыми  значениями.

значениями.

3. Уточнить веса по формулам (2.9) и (2.10) на основе результатов, полученных в п.1 и п.2 для исходной сети и для сети обратного распространения ошибки.

4. Пункты 1, 2, 3 повторить для всех обучающих выборок, вплоть до выполнения условия остановки: норма градиента станет меньше заданного значения e, характеризующего точность обучения.

Рассмотрим основные расчетные формулы для сети с одним скрытым слоем, представленной на рисунке 2.2. Используется сигмоидальная функция активации, при этом в случае гиперболического тангенса производная функции активации равна

(2.11)

(2.11)

В случае логистической функции производная равна

(2.12)

(2.12)

В формулах (2.11) и (2.12) под переменной u будем понимать выходные сигналы сумматоров нейронов скрытого или выходного слоя, представленных формулами (2.13) и (2.14).

(2.13)

(2.13)

(2.14)

(2.14)

Уточнение весовых коэффициентов будем проводить после предъявления каждой обучающей выборки. Минимизация ведется методом градиентного спуска, что означает подстройку весовых коэффициентов следующим образом:

(2.15)

(2.15)

(2.16)

(2.16)

Здесь  – весовой коэффициент синаптической связи, соединяющей i-ый нейрон слоя m с j-ым нейроном слоя m-1,h – коэффициент обучения, 0<h<1.

– весовой коэффициент синаптической связи, соединяющей i-ый нейрон слоя m с j-ым нейроном слоя m-1,h – коэффициент обучения, 0<h<1.

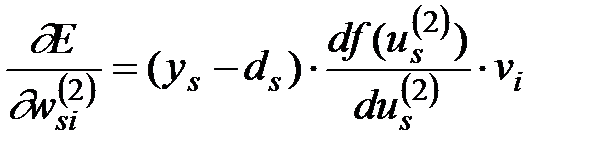

С учетом принятых на рисунке 2.3 обозначений целевая функция для выходного слоя нейронов определяется следующим образом:

(2.17)

(2.17)

(2.18)

(2.18)

Здесь под  , как и раньше, подразумевается выход s –го нейрона.

, как и раньше, подразумевается выход s –го нейрона.

Компоненты градиента относительно нейронов скрытого слоя описываются более сложной зависимостью:

(2.19)

(2.19)

В другом виде эта зависимость может быть выражена формулой:

(2.20)

(2.20)

|

из

5.00

|

Обсуждение в статье: Алгоритм обратного распространения ошибки |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы