|

Главная |

Многомерная оптимизация. Метод наискорейшего спуска (метод Коши).

|

из

5.00

|

Многомерная оптимизация - оптимизация при нескольких управляющих переменных

Методы, использующие только значения функции:

ü Метод покоординатного спуска (метод Гаусса);

ü Метод деформируемого многогранника (симплексный метод);

ü Метод Хука–Дживса;

ü Алгоритм Розенброка;

ü Метод Пауэлла и сопряженные направления.

Методы, требующие вычисления первых производных функции (градиента):

ü Метод градиентного спуска;

ü Метод Ньютена;

ü Метод сопряженных градиентов;

ü  Многопараметрический поиск.

Многопараметрический поиск.

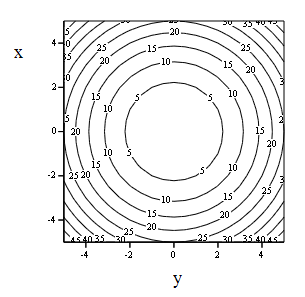

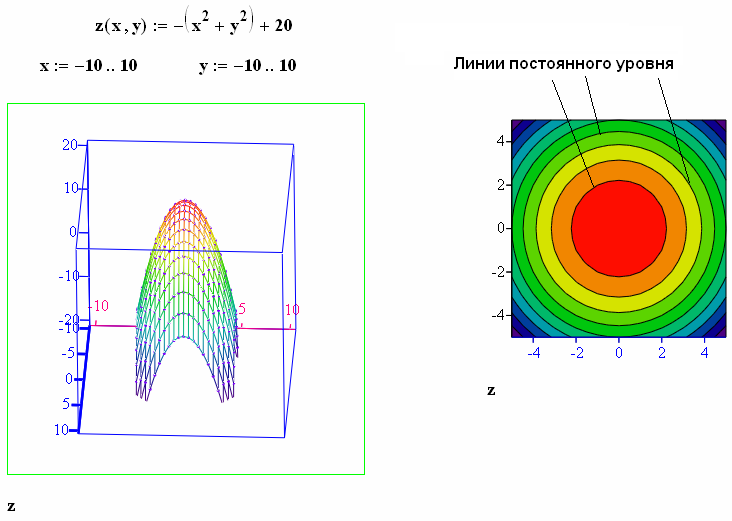

Линии постоянного уровня. «Рельеф функции» удобно рассмотреть на примере функции двух переменных z= F( x, y). Это функция описывает некоторую поверхность в трехмерном пространстве с координатами z, x, y. Задача F( x, y)→ min означает поиск низшей точки этой поверхности. Проведем сечения поверхности равно отстоящими плоскостями, которые параллельны плоскости изменения

переменных x и y. Линии этих сечений проецируем на плоскость изменения переменных. Получим концентрические окружности.

переменных x и y. Линии этих сечений проецируем на плоскость изменения переменных. Получим концентрические окружности.

Эти линии называются линиями постоянного уровня. Основная характеристика любой из линий это то, что в любой точке этой линии значение функции постоянно.

К методам первого порядка относятся алгоритмы, в которых в процессе поиска кроме информации о самой функции используется информация о производных первого порядка. К группе таких методов относятся различные градиентные методы:

ü Метод градиентного спуска;

ü Метод наискорейшего спуска;

ü Метод сопряженных градиентов;

ü Многопараметрический поиск.

Градиентфункции - вектор, показывающий направление наибольшего локального возрастания функции f( x). При поиске минимума функции f( x), следует двигаться в направлении противоположном направлению градиента в данной точке (антиградиент).

Градиентфункции - вектор, показывающий направление наибольшего локального возрастания функции f( x). При поиске минимума функции f( x), следует двигаться в направлении противоположном направлению градиента в данной точке (антиградиент).

Антиградиент - вектор, противоположный градиенту функции f( x) и, следовательно, направленный в сторону ее наискорейшего убывания.

Градиент перпендикулярен касательной к линии постоянного уровня. Если в какой-то точке градиент равен 0, то такая точка называется стационарной.

Если критерий оптимизации задан функцией:

то его градиент в некоторой точке

(из области определения функции) определяется вектором:

Если критерий оптимизации задан аналитически, то вычисление градиента не представляет принципиальных трудностей. Однако, при оптимизации систем критерий оптимизации, как правило, задан в виде неявной функции. В этом случае частные производные в точке находят приближенными методами.

Δх i - бесконечно малое приращение (1 - 5% от значения i - ой переменной).

|

из

5.00

|

Обсуждение в статье: Многомерная оптимизация. Метод наискорейшего спуска (метод Коши). |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы