|

Главная |

Многослойные сети прямого распространения

|

из

5.00

|

Другой класс нейронных сетей прямого распространения характеризуется наличием одного или нескольких скрытых слоев (bidden layer), узлы которых называются скрытыми нейронами (hidden neuron), или скрытыми элементами (hidden unit). Функция последних заключается в посредничестве между внешним входным сигналом и выходом нейронной сети. Добавляя один или несколько скрытых слоев, мы можем выделить статистики высокого порядка.

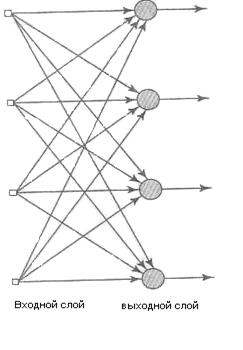

Рисунок 1.1 - Сеть прямого распространения с одним слоем нейронов

Такая сеть позволяет выделять глобальные свойства данных помощью локальных соединений за счет наличия дополнительных синаптических связей и повышения уровня взаимодействия нейронов. Способность скрытых нейронов выделять статистические зависимости высокого порядка особенно существенна, когда размер входного слоя достаточно велик.

Узлы источника входного слоя сети формируют соответствующие элементы шаблона активации (входной вектор), которые составляют входной сигнал, поступающий на нейроны (вычислительные элементы) второго слоя (т.е. первого скрытого слоя). Выходные сигналы второго слоя используются в качестве входных для третьего слоя и т.д. Обычно нейроны каждого из слоев сети используют в качестве входных сигналов выходные сигналы нейронов только предыдущего слоя. Набор выходных сигналов нейронов выходного (последнего) слоя сети определяет общий отклик сети на данный входной образ, сформированный узлами источника входного (первого) слоя. Сеть, показанная на рис. 1.1, называется сетью 10-4-2, так как она имеет 10 входных, 4 скрытых и 2 выходных нейрона. В общем случае сеть прямого распространения с m входами, h1нейронами первого скрытого слоя, h2 нейронами второго скрытого слоя и q нейронами выходного слоя называется сетью m — h1— h2—q-

Нейронная сеть, показанная на рис. 1.1, считается полносвязной (fully connected) в том смысле, что все узлы каждого конкретного слоя соединены со всеми узлами смежных слоев. Если некоторые из синаптических связей отсутствуют, такая сеть называется неполносвязной (partially connected).

1.4 Инварианты в структуре нейронной сети

Рассмотрим следующие физические явления.

• Если исследуемый объект вращается, то соответствующим образом меняется и его образ, воспринимаемый наблюдателем.

• В когерентном радаре, обеспечивающем информацию об амплитуде и фазе источников окружающей среды, эхо от движущегося объекта смещено по частоте. Это связано с эффектом Доплера, который возникает при радиальном движении объекта наблюдения относительно радара.

• Диктор может произносить слова как тихим, так и громким голосом, как медленно, так и скороговоркой.

Для того чтобы создать систему распознавания объекта, речи или эхо-локации, учитывающую явления такого рода, необходимо принимать во внимание диапазон трансформаций (transformation) наблюдаемого сигнала. Соответственно основным требованием при распознавании образов является создание такого классификатора, который инвариантен к этим трансформациям. Другими словами, на результат классификации не должны оказывать влияния трансформации входного сигнала, поступающего от объекта наблюдения.

Существуют как минимум три приема обеспечения инвариантности нейронной сети классификации к подобным трансформациям.

1. Структурная инвариантность (invariance by structure). Инвариантность может быть привнесена в нейронную сеть с помощью соответствующей структуризации. В частности, синаптические связи между отдельными нейронами сети строятся таким образом, чтобы трансформированные версии одного и того же сигнала вызывали один и тот же выходной сигнал. Рассмотрим для примера нейросетевую классификацию входного сигнала, которая должна быть инвариантна по отношению к плоскому вращению изображения относительно своего центра. Структурную инвариантность сети относительно вращения можно выразить следующим образом. Пусть Wji — синаптический вес нейрона j, связанного с пикселем i входного изображения. Если условие Wji = Wjk выполняется для всех пикселей j и k, лежащих на равном удалении от центра изображения, нейронная сеть будет инвариантной к вращению. Однако, для того чтобы обеспечить инвариантность относительно вращения, нужно дублировать синаптические веса Wji всех пикселей, равноудаленных от центра изображения. Недостатком структурной инвариантности является то, что количество синаптических связей изображения даже среднего размера будет чрезвычайно велико.

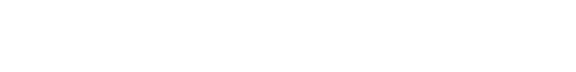

Рисунок 1.2 - Диаграмма системы, использующей пространство инвариантных признаков

2. Инвариантность по обучению (invariance by training). Нейронные сети обладают естественной способностью классификации образов. Эту способность можно использовать для обеспечения инвариантности сети к трансформациям. Сеть обучается на множестве примеров одного и того же объекта, при этом в каждом примере объект подается в несколько измененном виде (например, снимки с разных ракурсов). Если количество таких примеров достаточно велико и если нейронная сеть обучена отличать разные точки зрения на объект, можно ожидать, что эти данные будут обобщены и сеть сможет распознавать ракурсы объекта, которые не использовались при обучении. Однако с технической точки зрения инвариантность по обучению имеет два существенных недостатка. Во-первых, если нейронная сеть была научена распознавать трансформации объектов некоторого класса, совсем не обязательно, что она будет обладать инвариантностью по отношению к трансформациям объектов других классов. Во-вторых, такое обучение является очень ресурсоемким, особенно при большой размерности пространства признаков.

3. Использование инвариантных признаков (invariant feature space). Третий метод создания инвариантного нейросетевого классификатора проиллюстрирован на рис. 1.2. Он основывается на предположении, что из входного сигнала можно выделить информативные признаки, которые описывают самую существенную информацию, содержащуюся в наборе данных, и при этом инвариантны к трансформациям входного сигнала. При использовании таких признаков в нейронной сети не нужно хранить лишний объем информации, описывающей трансформации объекта. В самом деле, при использовании инвариантных признаков отличия между разными экземплярами одного и того же объекта могут быть вызваны только случайными факторами, такими как шум. Использование пространства инвариантных признаков имеет три важных преимущества. Во-первых, уменьшается количество, признаков, которые подаются в нейронную сеть. Во-вторых, ослабляются требования к структуре сети. И, в-третьих, гарантируется инвариантность всех объектов по отношению к известным трансформациям. Однако этот подход требует хорошего знания специфики проблемы.

Итак, из вышесказанного можно сделать вывод, что использование инвариантных признаков является наиболее подходящим методом для обеспечения инвариантности нейросетевых классификаторов.

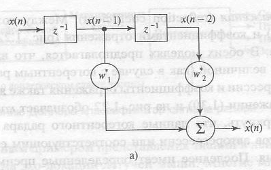

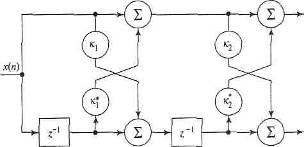

Рисунок 1.3 - Модель авторегрессии второго порядка: модель фильтра на линии задержки с отводами (а) и модель решетчатого фильтра (б).

Чтобы проиллюстрировать идею пространства инвариантных признаков, рассмотрим в качестве примера систему когерентного радара, используемую авиадиспетчерами, во входном сигнале которой может содержаться информация, поступающая от самолетов, стаи птиц и некоторых погодных явлений. Сигнал радара, отраженный от различных целей, имеет разные спектральные характеристики. Более того, экспериментальные исследования показали, что сигнал такого радара можно промоделировать с помощью авторегрессионного процесса (AR-процесса) среднего порядка (autoregressive process of moderate order). AR-процесс представляет собой особый вид регрессионной модели, описываемой следующим образом:

(1.1)

(1.1)

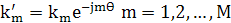

где  — коэффициенты (coefficient) авторегрессии; М — порядок модели (model order); x(n) — входной сигнал (input signal); e(n) — помеха (error), представляющая собой белый шум. Модель, описанная формулой (1.1), представляет собой фильтр на линии задержки с отводами (tapped-delay-line filter), показанный на рис. 1.3, а для М = 2. Аналогично, ее можно представить как решетчатый фильтр (lattice filter), показанный на рис. 1.3, б, коэффициенты которого называются коэффициентами отражения (reflection coefficient). Между коэффициентами авторегрессии (рис. 1.3, а) и коэффициентами отражения (рис. 1.3, б) существует однозначное соответствие. В обеих моделях предполагается, что входной сигнал x(n) является комплексной величиной (как в случае с когерентным радаром), в которой коэффициенты авторегрессии и коэффициенты отражения также являются комплексными. Звездочка в выражении (1.1) и на рис. 1.3 обозначает комплексное сопряжение. Здесь важно подчеркнуть, что данные когерентного радара можно описать множеством коэффициентов авторегрессии или соответствующим ему множеством коэффициентов отражения. Последнее имеет определенные преимущества в плане сложности вычислений. Для него существуют эффективные алгоритмы получения результата непосредственно из входных данных. Задача выделения признаков усложняется тем фактом, что движущиеся объекты характеризуются переменными доплеровскими частотами, которые зависят от скорости объекта относительно радара и создают искажения в спектре коэффициентов отражения, по которым определяются признаки. Для того чтобы обойти эту сложность, в процессе вычисления коэффициентов отражения следует использовать инвариантность Доплера (Doppler invariance). Угол фазы первого коэффициента отражения принимается равным доплеровской частоте сигнала радара. Соответственно для всех коэффициентов выполняется нормировка относительно доплеровской частоты, устраняющая влияние сдвига доплеровской частоты. Для этого определяется новое множество коэффициентов отражения кm, связанных с множеством исходных коэффициентов отражения Кm следующим соотношением:

— коэффициенты (coefficient) авторегрессии; М — порядок модели (model order); x(n) — входной сигнал (input signal); e(n) — помеха (error), представляющая собой белый шум. Модель, описанная формулой (1.1), представляет собой фильтр на линии задержки с отводами (tapped-delay-line filter), показанный на рис. 1.3, а для М = 2. Аналогично, ее можно представить как решетчатый фильтр (lattice filter), показанный на рис. 1.3, б, коэффициенты которого называются коэффициентами отражения (reflection coefficient). Между коэффициентами авторегрессии (рис. 1.3, а) и коэффициентами отражения (рис. 1.3, б) существует однозначное соответствие. В обеих моделях предполагается, что входной сигнал x(n) является комплексной величиной (как в случае с когерентным радаром), в которой коэффициенты авторегрессии и коэффициенты отражения также являются комплексными. Звездочка в выражении (1.1) и на рис. 1.3 обозначает комплексное сопряжение. Здесь важно подчеркнуть, что данные когерентного радара можно описать множеством коэффициентов авторегрессии или соответствующим ему множеством коэффициентов отражения. Последнее имеет определенные преимущества в плане сложности вычислений. Для него существуют эффективные алгоритмы получения результата непосредственно из входных данных. Задача выделения признаков усложняется тем фактом, что движущиеся объекты характеризуются переменными доплеровскими частотами, которые зависят от скорости объекта относительно радара и создают искажения в спектре коэффициентов отражения, по которым определяются признаки. Для того чтобы обойти эту сложность, в процессе вычисления коэффициентов отражения следует использовать инвариантность Доплера (Doppler invariance). Угол фазы первого коэффициента отражения принимается равным доплеровской частоте сигнала радара. Соответственно для всех коэффициентов выполняется нормировка относительно доплеровской частоты, устраняющая влияние сдвига доплеровской частоты. Для этого определяется новое множество коэффициентов отражения кm, связанных с множеством исходных коэффициентов отражения Кm следующим соотношением:

(1.2)

(1.2)

где q — фазовый угол первого коэффициента отражения. Операция, описанная выражением (1.2), называется гетеродинированием (heterodyning). Исходя из этого, набор инвариантных к смещению Доплера признаков (Doppler-invariant radar feature) представляется нормированными коэффициентами отражения к'1,к'2, ...,  -где

-где  — единственный коэффициент этого множества с вещественным значением. Как уже отмечалось, основными категориями объектов, выделяемых радарной установкой, являются стаи птиц, самолеты, погодные явления и поверхность земли. Первые три категории объектов являются движущимися, в то время как последняя — нет Гетеродинные спектральные параметры эха радара от земли аналогичны соответствующим параметрам эха от самолета. Отличить эти два сигнала можно по наличию у эха от самолета небольшого смещения Доплера. Следовательно, классификатор радара должен содержать постпроцессор. Он обрабатывает результаты классификации с целью идентификации класса земли. Препроцессор (preprocessor) обеспечивает инвариантность признаков по отношению к смещению Доплера, в то время как постпроцессор использует смещение Доплера для разделения объектов "самолет" и "земля" в выходном сигнале.

— единственный коэффициент этого множества с вещественным значением. Как уже отмечалось, основными категориями объектов, выделяемых радарной установкой, являются стаи птиц, самолеты, погодные явления и поверхность земли. Первые три категории объектов являются движущимися, в то время как последняя — нет Гетеродинные спектральные параметры эха радара от земли аналогичны соответствующим параметрам эха от самолета. Отличить эти два сигнала можно по наличию у эха от самолета небольшого смещения Доплера. Следовательно, классификатор радара должен содержать постпроцессор. Он обрабатывает результаты классификации с целью идентификации класса земли. Препроцессор (preprocessor) обеспечивает инвариантность признаков по отношению к смещению Доплера, в то время как постпроцессор использует смещение Доплера для разделения объектов "самолет" и "земля" в выходном сигнале.

|

из

5.00

|

Обсуждение в статье: Многослойные сети прямого распространения |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы