|

Главная |

Анализ главных компонентов на основе фильтра Хебба

|

из

5.00

|

Описанный в предыдущем разделе фильтр Хебба извлекает первый главный компонент из входного сигнала. Линейная модель с одним нейроном может быть расширена до сети прямого распространения с одним слоем линейных нейронов с целью анализа главных компонентов для входного сигнала произвольной размерности.

Для большей конкретизации рассмотрим сеть прямого распространения, показанную на рис. 8.6. В ней сделаны следующие допущения относительно структуры:

1. Все нейроны выходного слоя сети являются линейными.

2. Сеть имеет т входов и I выходов. Более того, количество выходов меньше количества входов (т.е. I <т).

Обучению подлежит только множество синаптических. весов {wji}, соединяющих узлы i входного слоя с вычислительными узлами j выходного слоя, где i = l,2,...,m; j = 1,2,..., l.

Выходной сигнал уi, (п) нейрона j в момент времени п, являющийся откликом на множество входных воздействий {xi(п) i = 1,2,..., m}, определяется по следующей формуле (рис. 8.7, а):

(1.35)

(1.35)

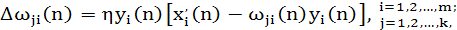

Синаптический вес wji(n) настраивается в соответствии с обобщенной формой правила обучения Хебба:

(1.36)

(1.36)

где wji(n) — коррекция, применяемая к синаптическому весу wji(n) в момент времени n; η — параметр скорости обучения. Обобщенный алгоритм обучения Хеббa (generalized Hebbian algorithm — GHA) (1.36) для слоя из l нейронов включает в себе алгоритм (8.39) для одного нейрона в качестве частного случая, т.е. для l = 1.

Для того чтобы заглянуть вглубь обобщенного алгоритма обучения Хебба, перепишем уравнение (8.80) в следующем виде:

(1.37)

(1.37)

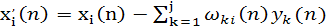

где х  (п) — модифицированная версия i-го элемента входного вектора х(n), являющаяся функцией индекса j, т.е.

(п) — модифицированная версия i-го элемента входного вектора х(n), являющаяся функцией индекса j, т.е.

(1.38)

(1.38)

Для конкретного нейрона j алгоритм, описанный выражением (1.37), имеет ту же математическую форму, что и (8.39), за исключением того факта, что в (1.38) входной сигнал xi(n) заменен его модифицированным значением х  (n). Теперь можно сделать следующий шаг и переписать выражение (1.37) в форме, соответствующей постулату обучения Хебба:

(n). Теперь можно сделать следующий шаг и переписать выражение (1.37) в форме, соответствующей постулату обучения Хебба:

(1.39)

(1.39)

где

(1.40)

(1.40)

Таким образом, принимая во внимание

(1.41)

(1.41)

и

(1.42)

(1.42)

где z-1 — оператор единичной задержки, можно построить граф передачи сигнала показанный на рис. 1.4, б, для обобщенного алгоритма Хебба. Из этого графа видно,

Рисунок 1.4 - Представление обобщенного алгоритма Хебба в виде графа передачи сигнала: граф уравнения (1.35) (а); граф выражений (1.36), (1.37) (б)

что сам алгоритм (согласно его формулировке в (1.41)) базируется на локальной форме реализации. Учтем также, что выход уi(n), отвечающий за обратную связь на графе передачи сигнала (см. рис. 1.4, б), определяется по формуле (1.35). Представление Для эвристического понимания того, как обобщенный алгоритм Хебба работает на самом деле, в первую очередь запишем версию алгоритма (1.37) в матричном представлении:

(1.43)

(1.43)

где

(1.44)

(1.44)

Вектор х'(п) представляет собой модифицированную форму входного вектора. Основываясь на представлении (1.43), можно сделать следующие наблюдения. Для первого нейрона сети прямого распространения:

Для этого случая обобщенный алгоритм Хебба сводится к виду (1.33), записанному для одиночного нейрона. Из материала, представленного в разделе 1.5.4, известно, что этот нейрон извлекает первый основной компонент входного вектора х(п).

1. Для второго нейрона сети можно записать:

Учитывая, что первый нейрон уже извлек первый главный компонент, второй нейрон видит входной вектор x'(n), из которого уже удален первый собственный вектор матрицы корреляции R. Таким образом, второй нейрон извлекает первый главный компонент х'(n), что эквивалентно второму главному компоненту исходного входного вектора х(n).

2. Для третьего нейрона можно записать:

Предположим, что первые два нейрона уже сошлись к первому и второму главным компонентам. Значит, третий нейрон видит входной вектор x'(n), из которого удалены первый и второй собственные векторы. Таким образом, он извлекает первый главный компонент вектора х'(n), что эквивалентно третьему главному компоненту исходного входного вектора х(n).

3. Продолжая эту процедуру для оставшихся нейронов сети прямого распространения, получим, что каждый из выходов сети, обученный с помощью обобщенного алгоритма Хебба (1.37), представляет собой отклик на конкретный собственный вектор матрицы корреляции входного вектора, причем отдельные выходы упорядочены по убыванию ее собственных значений.

Этот метод вычисления собственных векторов аналогичен методу, получившему название процесса исчерпания. Он использует процедуру, аналогичную ортогонализации Грама-Шмидта.

Представленное здесь описание "от нейрона к следующему нейрону" было приведено для упрощения изложения. На практике все нейроны в обобщенном алгоритм Хебба совместно работают на обеспечение сходимости.

|

из

5.00

|

Обсуждение в статье: Анализ главных компонентов на основе фильтра Хебба |

|

Обсуждений еще не было, будьте первым... ↓↓↓ |

Почему 1285321 студент выбрали МегаОбучалку...

Система поиска информации

Мобильная версия сайта

Удобная навигация

Нет шокирующей рекламы